La revue exit! consacre deux articles de sa livraison de 2024 à « critiquer » mes positions [1]. Je n’excuse pas la manière infâmante dont elle le fait : on me soupçonne entre autres, par insinuations fielleuses, d’antisémitisme, d’écofascisme, de sympathie populiste ou de défendre une idéologie de « l’identité et du sol », par quoi on masque la nullité de la « critique » qui m’est adressée. Je constate ainsi que les auteurs qui me critiquent n’ont rien compris à mes thèses sur la crise du covid et sur la question de l’énergie. Il est regrettable que l’on n’ait pas su produire, accueillir ou accompagner des développements théoriques nécessaires et croie maintenant en être quitte avec ces défis théoriques en traînant mes efforts afférents dans la boue. Je peux avoir énoncé une position contestable, mais je n’ai insulté personne du groupe exit! Et je demande que ma position soit évaluée à l’aune de mes arguments et non à partir d’un déchaînement de projections personnelles. Les auteurs et la rédaction d’exit! se disqualifient eux-mêmes par de tels procédés. Plus grave encore, ils gâtent ainsi leur propre noyau théorique au lieu de l’affûter, non sans cesser de se réclamer de l’ancienne splendeur de la Wertkritik.

Ce qui reste du coronavirus

Dans son article, Roswitha Scholz commente mes thèses exposées dans le texte « Théorie des théories du complot » [2]. Je lui reconnais davantage de fermeté que moi envers les réactions contre la politique sanitaire de certains ex-membres d’exit!. Les contours idéologiques de certaines de ces réactions sont par ailleurs plus clairs un an après. Mais je récuse qu’on puisse rétroactivement et en bloc traiter de complotistes tous ceux qui ont manifesté en 2022 un malaise au sein du groupe exit! – et ailleurs – sur la question de la politique sanitaire. Ce malaise recouvre une gamme de positions dont le mouvement des antivax n’est qu’une extrémité. Se réfugier dans la dénonciation d’un extrême permet à Scholz de négliger totalement la complexité de l’objet.

Ai-je parlé de tolérer des complotistes au sein du groupe exit! ? Non, je n’ai fait que parler d’un débat qui n’a pas eu lieu sur la politique sanitaire. Je n’ai rien à dire sur le fait que les textes de Jappe, Urban et Uhnrast n’ont pas été publiés par exit! et ne me suis donc pas plainte de ceci, contrairement à ce qui est dit. J’estime seulement qu’ils auraient dû être discutés avec les intéressés avant d’être refusés. Se séparer en l’absence d’un tel débat – le plus pointu possible – obère l’aiguisement du projet théorique des deux côtés. Scholz considère comme scandaleux qu’on puisse convier ceux qu’elle appelle les antivax et ceux qu’elle estime des théoriciens sérieux à la même table pour un débat « symétrique » (car on ne discute pas avec le diable), et elle a donc agi sur la base d’un jugement anticipé qui a rejeté par avance l’objet du débat en même temps que les personnes qui le faisaient émerger. Elle semble se croire ainsi libérée d’avoir à fournir un effort théorique sur la question de la politique sanitaire, puisqu’il suffit de crier haro sur les affreux. L’effort qui serait à fournir est détourné sur une surface de projection (le groupe sociologique des antivax) qui devient ainsi le « mauvais objet » du processus de décomposition global, non replacé dans une analyse structurelle. La focalisation agressive et grossière – qui se prend pour un geste militant – sur les personnages scandaleux ne constitue en rien une théorie critique. Elle n’est qu’une alternative à cette autre critique personnifiante, celle contre les élites, que la critique de la valeur-dissociation refuse à raison comme tronquée.

Contrairement à ce qui est affirmé par Scholz, je n’ai jamais dit que « l’harmonie » aurait couronné ou devait nécessairement couronner le débat qui n’a pas eu lieu. Je dis que le déroulement du conflit a été bloqué dans le groupe par l’absence de débat, y compris pour ceux qui n’ont pas de vocation complotiste mais qui ont, de fait, été assimilés à des sympathisants du complotisme (comme je le suis en toute logique moi-même maintenant). Le débat n’aurait probablement fait changer personne d’avis, mais il aurait fait émerger l’objet qui est resté dans l’ombre : la politique sanitaire. L’objet fut congédié en même temps que les personnes. La contradiction non traitée fut coupée en deux moitié vaquant ensuite chacune de leur côté. Et ainsi le terrain fut balayé pour une nullité théorique qui ne fait que se confirmer. Lorsque j’écrivais « n’aurait-on pas pu éviter ça ? », il est clair que je parlais du traitement de la contradiction, transformé en insultes, et non du sort individuel des protagonistes à l’issue d’un débat honnêtement mené.

Mon texte « Théories des théories du complot » traitait de cette contradiction objective. Je n’ai en aucun cas critiqué les mesures sanitaires en tant que telles, pas plus que je n’ai défendu ou justifié une opposition absolue contre ces mesures (opposition qui était celle des antivax). De mon incompétence en matière épidémiologique ne s’ensuit pas une confiance aveugle dans les tendances politiques autoritaires et le cynisme des acteurs de l’industrie pharmaceutique. Inversement, mon impuissance réelle devant ces tendances cyniques et autoritaires ne justifie pas de nier toute utilité immédiate du vaccin dans une mesure circonscrite. S’il me parait évident que nous devons par « réalisme pragmatiste » (Scholz) exiger de l’État toutes les mesures nécessaires (confinement aussi prolongé que nécessaire, capacités hospitalières, fourniture suffisante de masques, médicaments et respirateurs artificiels, etc.), il me paraît tout aussi évident que nous devons fermement refuser la transformation de la politique de santé publique en dispositifs autoritaires de contrôle, de surveillance et d’intimidation. Mon propos se situait précisément à l’intersection de cette contradiction, car c’est à l’endroit de son impuissance – l’épuisement structurel de ses capacités – que l’État-providence se transforme en un état d’exception purement répressif. La question du point de bascule est donc une question logique. Voilà ce qui nécessite une analyse spécifique. D’où mon insistance sur le débat autour de la vaccination obligatoire qui constituait selon moi un élément charnière de cette contradiction logique.

Les polarités idéologiques devaient donc être replacées dans la configuration structurelle qui se manifestait ici. Je ne nie pas les nombreuses contributions généralistes d’exit! sur ce point. Mais exit! n’a fourni aucune analyse effective de la politique sanitaire. Mon texte développait une argumentation précise : 1/ la totale incohérence des prétendues mesures sanitaires dues aux contradictions structurelles de l’État ; 2/ la campagne de vaccination et la discussion de la rendre obligatoire comme résolution suprême (répressive et biopolitique) des contradictions non traitées que manifestaient précisément ces incohérences ; 3/ le spectre de plus en plus accepté d’une généralisation de cette gestion-là, inhérente à la machine de mort qu’est le capitalisme – et qui équivaut à un survivalisme statistique et structurel ; 4/ le développement toujours plus aigu et concomitant d’un irrationalisme complotiste poussant sur fond d’affirmation elle aussi toujours plus aiguë de la raison d’État et de la technoscience positiviste. Je tiens ces deux développements complémentaires pour deux formes de paranoïas qui se répondent en miroir, dans une structure globale qui est elle-même paranoïde. Il convient donc de ne pas les traiter séparément en théorie.

Je donnais en effet à la vaccination de masse (et la série d’intimidations qui l’accompagnait de la part des autorités) une fonction particulière dans le traitement de la crise. Elle était le point tournant de mon argumentation, systématiquement ignoré par Scholz. Les quatre aspects de l’argumentation nommés ci-dessus sont dialectiquement indissociables. Scholz les commente par morceaux sans prendre en compte leur logique. Elle m’accuse d’ignorer les réflexions d’exit! sur « le rapport complexe entre l’État, la répression, le libéralisme et les contradictions qui en découlent » (p. 232). C’est justement parce que je les ai prises au sérieux qu’il me sembla nécessaire d’aborder la crise sanitaire à la lumière de cette approche. Elle-même semble considérer ces analyses générales comme faites une fois pour toutes et coulées dans le béton, sans qu’il soit nécessaire de les mettre à l’épreuve pour l’analyse de nouveaux événements. Scholz me reproche de n’avoir pas pris connaissance des contributions d’autres auteurs d’exit! sur le sujet, ce qui n’est pas le cas. Mais les dizaines de pages sur la crise du covid dont elle se réclame n’évoquent le deuxième et le troisième aspect que de manière sporadique, sans jamais dégager la dialectique interne des quatre aspects que je relie entre eux. Les textes d’exit! versent pour cette raison dans une fixation unilatérale sur le premier et le quatrième aspect, surtout le complotisme, c’est-à-dire un seul côté de l’idéologie. Il y manque l’analyse du rapport interne spécifique de cette situation-là, c’est-à-dire aussi de ses contradictions actuelles. Il ne suffit pas de dire qu’il y a « un rapport en général ». Cette généralité est la mort de la théorie. La « contradiction en procès » n’est pas identique à elle-même, justement parce qu’elle est en procès. Le rapport ne doit jamais cessé d’être mise en évidence à partir des événements empiriques, non pas pour « confirmer » une théorie considérée comme toute-puissante, mais au contraire pour vérifier et actualiser la contradiction à partir de nouvelles coordonnées. L’examen du banal, du déroutant et du contradictoire y est incontournable. Je descends donc dans ma propre perplexité. Je ne considère pas que l’explication est toute prête. J’ai donc mené un raisonnement avec les moyens et les données qui me semblaient pertinents. Scholz me reproche également mon « ignorance sans fond » (p. 234) des textes de Thomas Meyer sur la numérisation et l’intelligence artificielle : là aussi, ce n’est pas le cas. Mais ces textes aussi n’avaient rien à proposer en termes d’interprétation acérée de la politique sanitaire, et reliée à la situation globale.

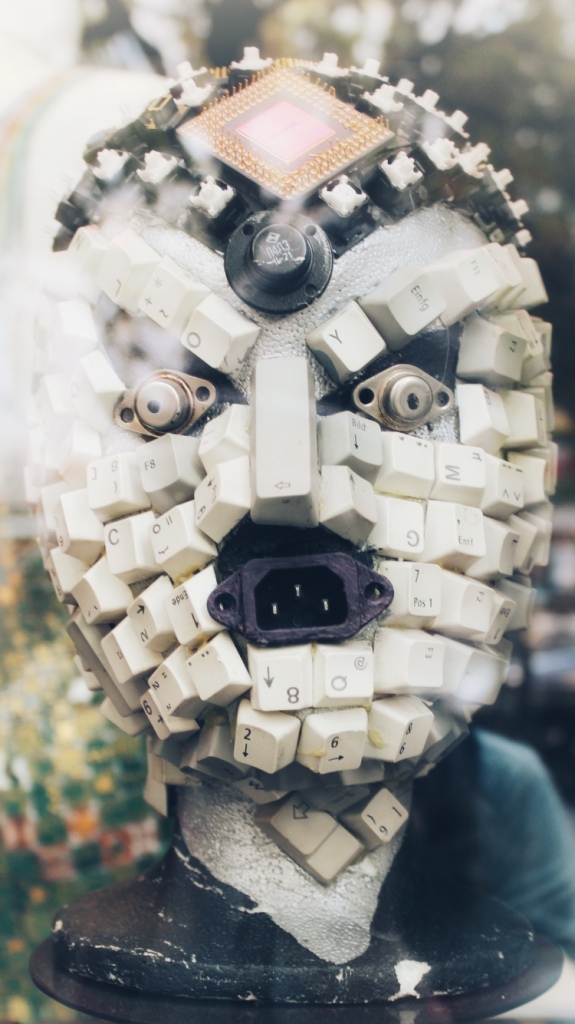

Scholz considère ce que j’appelais le risque de « dictature des moyens techniques » non comme le profil de réalité du capitalisme actuel mais comme « des philosophies de la technique et des utopies absurdes » (p. 234). Nous ne vivons donc pas dans le même monde, le monde du capitalisme de surveillance et de tous les systèmes automatisés : drones tueurs, cyberguerre, intelligence artificielle, milliards de caméras de surveillance, projet d’identité numérique européenne croisant toutes les données personnelles, dispositifs techniques dégradants contre les migrants aux frontières, etc. Tout ceci n’est pas une « dictature des moyens techniques » pour Scholz. Il faut donc parler de « domination impersonnelle du capital » sans parler de la domination afférente des moyens techniques ! Les automates du « sujet automate » n’auraient donc rien à voir avec le sujet automate ! Sait-on jamais, comme on verra peu après, toutes ces créations pourraient peut-être en outre nous rendre service dans un monde « émancipé » !

Scholz se contente, dans sa réplique, de réchauffer la soupe que je n’ai pas mangée en citant les textes de sa propre troupe. Elle ne présente aucune source extérieure. Son argument principal est d’expliquer pourquoi les antivax sont des gens infréquentables, sans autre analyse personnelle sur la crise du covid. Les antivax réalisent ainsi une performance exceptionnelle : non seulement ils ne pensent pas la situation globale, mais ils constituent le parfait alibi pour épargner aussi aux autres de la penser ! En me taxant d’un « geste de supériorité présomptueuse » (p. 230) et de me croire « au-dessus de la mêlée » (p. 233) sans examiner l’enchainement logique de mes arguments, Scholz retourne maintenant contre moi l’anti-intellectualisme primaire des adversaires habituels de la critique de la valeur.

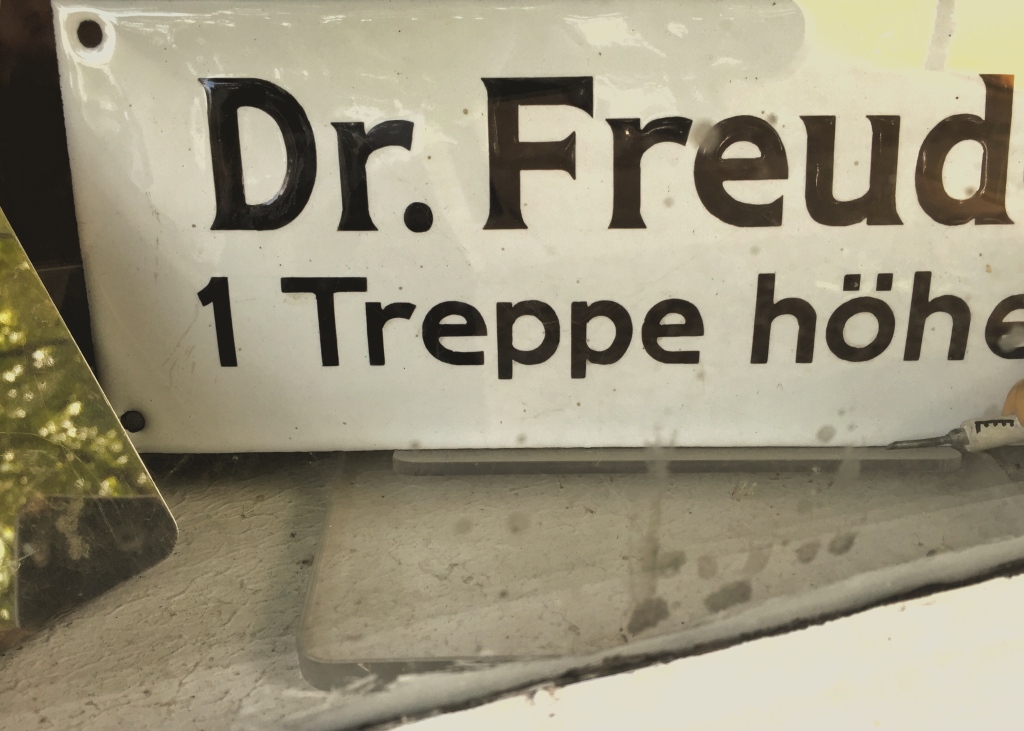

Scholz m’accuse aussi de faire preuve de « compréhension » envers les complotistes et de « justification implicite des positions populistes » lorsque je cite la remarque de Freud sur les constructions délirantes (p. 237). Elle prend ainsi l’expression freudienne « noyau de vérité » [Wahrheitskern] au sens positiviste immédiat, comme si j’affirmais que les complotistes disent, quelque part, positivement la vérité. Son accusation est tellement à côté du sujet qu’elle me laisse sans voix. J’ai dû me tromper en pensant que la critique de la valeur ne visait pas une dénonciation personnifiante de l’idéologie mais une analyse de ses conditions structurelles, et donc de leur noyau de vérité. Depuis quand chercher à comprendre l’émergence d’un phénomène extrême consiste-t-il à faire preuve de complaisance à son égard ? En cherchant à comprendre le fonctionnement réel du capitalisme, je suis donc complice du capitalisme ? Si j’applique à Scholz sa propre grille de lecture, dois-je comprendre son évocation de l’attaque du Hamas et de l’antisémitisme dans le monde, assorti d’un silence sur la situation actuelle à Gaza (p. 243) comme une complaisance envers les massacres du raciste d’extrême-droite Netanyahou, sans parler du fait que Netanyahou a pu tenir lui-même dans le passé des propos révisionnistes qui dédouanent Hitler de la Shoah ? Ou bien doit-elle toujours couvrir une extrémité du spectre idéologique pour dénoncer l’autre ?

Je commenterai maintenant la phrase suivante de Scholz : « Même dans le cas où les données statistiques ne permettent pas d’affirmer que le covid est dangereux, il relève du bon sens de porter un masque par précaution. » (p. 240). Significativement, Scholz parle du masque et non du projet de vaccination obligatoire qui était l’objet de mon texte. Mais que signifie ici : « il relève du bon sens… » ? Le débat que j’introduisais ne porte pas sur le bon sens individuel dans l’appréciation du risque de contamination. Je peux convenir individuellement qu’il est avisé de porter un masque dans certaines situations en cas de pandémie. Mais il s’agit, dans le débat qui n’a pas eu lieu, de discuter de la signification des mesures de masse, et ce pas seulement dans leur rapport à un danger précis, le virus, mais dans leur rapport au déroulement global de la crise. Je proposais d’éloigner la focale de l’immédiateté empirique (conformément aux attendus fondamentaux de la critique de la valeur-dissociation) et de la porter sur la gestion politique des risques planétaires et leur trajectoire. Scholz préfère dans cette affaire rester obstinément le nez collé sur l’immédiateté du virus au nom du « pragmatisme réaliste ». Je ne discute pas le bien-fondé d’un pragmatisme réaliste individuel mais sa signification politique : la vaccination de masse était destinée à couvrir non seulement les incuries de la gestion de crise, mais aussi le délitement structurel des structures de soin, la progression des instruments de contrôle et la trajectoire mortifère du capitalisme – et à se présenter pour finir comme le couronnement d’une gestion efficace susceptible de servir de modèle à la gestion d’autres crises.

Transposons cet énoncé dans une problématique voisine que j’évoque déjà dans mon texte « Théories des théories du complot » : « Même dans le cas où les données statistiques ne permettent pas d’affirmer que fumer est dangereux, il relève du bon sens de cesser de fumer par précaution. » L’individu fumeur reste libre de prendre en compte cet énoncé ou non : il ne contribue pas à propager une maladie mortelle. Mais le tabac, comme on sait, est un problème de santé publique réputé tuer 7 millions de personnes par an dans le monde. Le fumeur mobilise des moyens médicaux qui pourraient devenir cruciaux pour des personnes qui n’ont pas de « vice ». Donc le fumeur malade pourrait se voir mis en concurrence avec d’autres malades dans le cadre d’un système de santé de plus en plus insolvable. Il doit donc arrêter de fumer pour ne pas devoir, le cas échéant, usurper par sa négligence les soins d’un « vrai malade ». Il n’est pas exclu qu’il faille interpréter ainsi la discussion qui se déroule actuellement au Royaume-Uni autour d’une interdiction totale de la vente de tabac à la nouvelle génération de fumeurs. Scholz est-elle, au nom de la solidarité, favorable à la « prohibition » (qui vaut pour toutes les substances nocives ayant un coût pour le système de santé publique) ?

Dans le même esprit, certaines personnes âgées ont préféré prendre un risque d’attraper le covid que de se faire vacciner et d’autres ont préféré s’imposer un confinement prolongé que de se faire vacciner. A l’encontre d’un tel choix, certains pays ont pris des mesures autoritaires de vaccination obligatoire de toute la population ou d’une tranche âgée de la population (Autriche, Indonésie, Équateur, Turkménistan, Tadjikistan, Nouvelle-Calédonie, Micronésie, Grèce, Italie). D’autres États en ont seulement débattu en traitant la petite frange de non-vaccinés de fauteurs de pandémie. Scholz se garde de dire si une telle mesure politique « relève du bon sens » ou est problématique. Elle évite carrément le sujet tout au long de sa réponse et ne propose rien d’autre que d’avoir une discussion de comptoir « tranquillement en prenant un café » (p. 239).

Proposons une transposition encore plus crue de la même phrase de Scholz. « Même dans le cas où les données statistiques ne permettent pas d’affirmer que le réchauffement climatique est dangereux, il est relève du bon sens de devenir tous vegan par précaution. » (Le véganisme universel est promu par certains comme l’une des mesures capables de réduire considérablement les gaz à effets de serre : je la considère, telle la vaccination de masse, comme l’une des voies biopolitiques possible de fausse résolution de la contradiction non traitée.) On convient que cette fois, il ne s’agit plus de décision individuelle. Il ne s’agit pas de ma seule survie. Si je veux éviter que la moitié de l’humanité ne se retrouve prochainement dans des régions inhabitables, comme le prévoient certains scénarios, « il relève du bon sens » que j’exige la généralisation de cette première mesure. On dira peut-être qu’elle est insuffisante au regard de l’envergure du problème. Qu’à cela ne tienne : on peut allonger à loisirs le nombre des interdictions permettant d’atteindre le chiffre souhaité de réduction des émissions de gaz à effet de serre pour ne rien changer du mode de production capitaliste. Car je le rappelle, il ne s’agit pas avec la politique de sauver l’humanité mais de sauver des chiffres. Ainsi, par « pragmatisme réaliste », on protègerait les superflus et les vulnérables qui d’ores et déjà subissent le réchauffement climatique de plein fouet. N’étant pas « social-darwiniste », Scholz devrait soutenir les actions d’Extinction Rebellion (qui demandent la déclaration d’un état d’urgence climatique) par égard pour toutes les victimes du réchauffement climatique et, à terme, par égard pour la survie de l’humanité. Celui qui ne défend pas le véganisme et l’écologisme radical aujourd’hui est ainsi assurément un « darwiniste social » sacrifiant à leur sort des millions de malheureux présents et futurs. J’attends impatiemment que Scholz nous en fournisse la démonstration. Alors on pourra discuter de savoir qui est le plus « écofasciste » !

Ces exemples visent à ramener le débat au niveau exigible. Je demande qu’on examine dans toutes ces conséquences ce qu’implique l’assentiment au paradigme moderne et biopolitique de la gestion statistique des vies. Jusqu’où autoriserons-nous l’État à intervenir pour « sauver des vies » ou pour « sauver la planète » (voir ici l’approche technocratique intégrative appelée « one health » qui développe un concept unitaire de santé humaine, animale et environnementale) ? La crise de reproduction du capitalisme – la crise de la valorisation de la valeur – se manifeste en effet par une crise de reproduction de toutes les bases de la vie qui sont en même temps ses bases immédiatement sociales. Ceci ne fera que s’accentuer avec le temps. Jusqu’où tolérerons-nous, au plus intime de notre être physique et social, la gestion biocapitaliste de la vie et du vivant, quand on sait que tout est bon pour maintenir la machine de production mortifère ? Le porteur d’une « critique radicale » doit-il se soumettre muettement à l’état d’exception permanent pour sauver sa peau devant la montée des risques qui atteignent maintenant aussi les centres capitalistes (encore relativement à l’abri jusqu’à récemment) ? C’est cette question que la crise du covid nous commande de traiter. Scholz ne se soumet pas un instant à cette réflexion. Elle propose plutôt d’en discuter devant un café.

Si donc la phrase de Wolfgang Schäuble citée par Scholz « la vie n’est pas le bien suprême » (p. 240) témoigne bien du cynisme absolu de l’État lorsqu’il devient incapable de remplir ses fonctions attitrées, cette phrase est aussi la dénégation de la phrase « la vie est le bien suprême » et par là l’envers de la même médaille vitaliste et utilitariste : « la vie » exposée quotidiennement à la lutte pour son affirmation dans la concurrence. Une menace constante qui est aussi une exigence constante d’optimiser « la vie ». C’est pourquoi les deux formules ne cessent de se renverser l’une dans l’autre, comme Scholz ne semble pas s’en apercevoir. Le fait même d’évaluer abstraitement l’importance de « la vie » dans un sens absolu appartient strictement et uniquement à l’ethos capitaliste. La défense et la promotion de la « vie » ou sa négation la plus brutale sont des variantes de cette métaphysique moderne. Lorsque la vie est directement menacée (à cause de la maladie, de la vieillesse, d’une pandémie ou d’une guerre), c’est cette abstraction qui remonte encore plus clairement à la surface.

Pour agrémenter le tout, Scholz croit pouvoir enfoncer le clou en expédiant mon livre le Mur énergétique du capital en un peu plus d’une page. Elle ne le fait pas en discutant l’argumentation centrale du livre, qui ne l’intéresse pas puisqu’elle ne cite que la quatrième de couverture et deux phrases de la conclusion. Non, elle m’accuse gratuitement de « biocentrisme », « d’ethnopluralisme », « d’hostilité abstraite à la technique », de malthusianisme, de darwinisme social, de recourir « au concret immédiat, à la culture, à l’identité et au sol », ce qui justifie de me suspecter de flirter avec « l’antisémitisme » (p. 234-235). On ne pouvait pas formuler des accusations plus abjectes quand on sait quelles associations évoquent les mots « l’identité et le sol » dans le contexte de l’histoire de l’Allemagne. N’ayant rien de mieux à dire, on m’impute donc à demi-mot une idéologie néonazie. Cette offense est inexcusable.

Il est grotesque de voir des notions patiemment élaborées pendant des décennies – telle que celle d’antisémitisme structurel – devenir des insultes tirées à bout portant, dont mes textes sont maintenant aussi la cible, après d’autres que moi. La plus haute abstraction tombe au niveau personnel le plus immédiat. Cela n’a plus rien à voir avec une élaboration théorique rigoureuse mais avec un ruminement de signifiants transformés en slogans pour la galerie ou en flingue pour se liquider mutuellement. Lorsque le groupe exit! parle de barbarisation des rapports sociaux, il devrait commencer par mettre le nez dans son caca. En me traitant à demi-mot de nazie et en ne jugeant les autres qu’à l’aune de sa politique d’épuration Scholz, met réellement en acte ce qui se passe dans la société d’aujourd’hui. Le signifiant « nazi » est devenu un signifiant universel : le nazi, c’est l’autre, et tout le monde est le nazi de quelqu’un. Ce qui arrive au signifiant « juif » dans cette affaire, cela nécessite un examen approfondi que je ne ferai pas ici.

Retour sur le contexte de ma critique de la question énergétique et sur la réplique des auteurs d’exit !

Thomas Meyer consacre son article à critiquer mon livre Le mur énergétique du capital, en même temps qu’il reprend les thèses de Robert Kurz sur les artefacts de l’histoire, que je critique partiellement dans mon livre pour sa position hésitante sur le maintien des technologies industrielles. Dans ce contexte, le texte « Tabula rasa » de Kurz (2003) est réimprimé dans le même numéro de la revue exit!, comme si sa seule réimpression le plaçait au-dessus de toute critique !

Lorsque je commençai à écrire une recension du livre de Tomasz Konicz Klimakiller Kapital pour la revue Jaggernaut, j’ignorais en quoi se transformerait cette initiative. C’est en cours d’écriture qu’il m’apparut que la catégorie abstraite d’énergie sous-jacente – traitée par Konicz comme une simple catégorie matérielle – méritait un véritable examen dépassant le cadre d’une recension. L’énergie, au sens de la thermodynamique, est un thème qui m’obsède depuis longtemps et qui n’est pas extérieur au vocabulaire de la psychanalyse. C’est un thème difficile pour la non-scientifique que je suis. Mais je réclame la légitimité d’une compréhension profane qui permette d’éclairer de nouveaux aspects de la critique de l’économie politique et de la théorie freudienne des pulsions. C’est ainsi que ce qui devait être une recension n’a pas cessé de grandir pour devenir finalement un livre.

Or les affirmations de Konicz dont je cite quelques-unes dans mon livre ne font l’objet d’aucune critique, d’aucune distanciation, d’aucun débat au sein du groupe exit!. Ni Meyer ni Scholz n’en font la moindre mention dans leur réponse. J’en conclus qu’ils ne voient pas de problème au « communisme high-tech » que propose explicitement Konicz et approuvent le « potentiel d’une économie communiste en temps réel dans laquelle la demande de biens peut être immédiatement localisée et satisfaite. Le réseau de plus en plus dense d’appareils reliés à Internet permet de créer des chaînes de production ininterrompues qui se passeraient de la ˝main invisible˝ aveugle du marché : du champ au réfrigérateur en passant par la production et la distribution [3]. » Compte tenu de la violence de leur réponse à mes développements, je ne peux pas m’expliquer qu’ils tolèrent ces propos chez l’un de leurs contributeurs réguliers s’ils ne les approuvent pas. Konicz peut impunément défendre son « communisme high-tech » sans que personne ne lui cherche des poux, tandis que je suis assimilée par Meyer et Scholz aux écofascistes réactionnaires que je critique (p. 209, p. 235).

Or il en est allé avec mon livre Le mur énergétique comme il en est allé pour la discussion manquée sur la crise du covid : il ne m’a pas été possible d’en discuter avec le groupe exit!, cette discussion ayant été décommandée au nom d’ « autres priorités » puis remplacée par une proposition de discussion sur « zoom » que j’ai déclinée.

Parallèlement, mon article correspondant « Travail mort, travail vivant : le gouffre énergétique de la société du travail » [4] était décommandé de la revue exit! également au prétexte d’ « autres priorités » et se voyait offert une place sur le site, assorti d’une postface dans laquelle Meyer exprimait ses réserves de façon toute paternaliste, tout en ignorant complètement la thèse principale. Il reprend maintenant le même ton paternaliste en prétendant apporter un « supplément » (comme le dit le titre de son papier) à un livre auquel il n’a rien compris ! J’étais alors accusée d’hostilité à la technique, l’accusation reste à présent identique. Cet épisode fit pourtant l’objet d’un échange de courriels où j’exigeai qu’on commence par examiner mon argumentation avant d’en juger la conclusion. Je retirai finalement l’article de la publication sur le site d’exit!. Or Meyer réitère imperturbablement la même glose, mais seulement en infligeant au lecteur un plus grand nombre de pages.

Je prends ici son article comme occasion de répondre aussi à ceux qui, comme mus par un réflexe collectif dont ils ne sont pas conscients, m’opposent les mêmes objections que lui depuis la parution de l’ouvrage en allemand.

La critique anti-industrielle

On me reproche ici en long en large et en travers d’être hostile à la technique.

Première remarque. Il est vrai que le lecteur français n’associe pas immédiatement la critique anti-industrielle avec le mouvement néoromantique des Wandervogel ou la politique environnementale des nazis. Cette mémoire paraît chez certains lecteurs allemands, par un réflexe répulsif, bloquer tout accès à une critique catégorielle de la production industrielle, immédiatement associée au vaste fourre-tout des « anti-tech » réactionnaires. Je veux bien prendre en compte cette « différence culturelle », mais il y a un problème : je ne suis pas culturaliste. Lorsque je m’adresse à l’entendement de quelqu’un à l’aide d’arguments, je le suppose par provision capable de pénétrer une matière intellectuelle en surmontant ses préjugés de classe, de culture ou autre. Cette supposition minimale est certes rarement réalisée, mais si je ne la fais pas, la théorie et le débat d’idées ne font aucun sens.

Je n’ai moi-même aucune familiarité avec le courant de pensée anti-industriel français, ce qu’ont bien dû remarquer certains de ses auteurs puisque mon livre a été estampillé « marxiste » dans leur camp (eux aussi sont plus friands d’étiquettes que de « la patience du concept »). Je suis donc à la fois traitée de marxiste par des anti-industriels et accusée d’anti-industrialisme par des marxistes : j’en déduis que quelque chose a été touché de part et d’autre, à la jointure de leur double point aveugle. Je traite en effet de ce qui réunit ces deux frères ennemis dans une double critique, plus acérée des deux côtés. Ce point fait s’effondrer à la fois l’édifice progressiste moderne et son doublon inséparable, le pessimisme culturel, issu d’une critique simplement réactionnaire et phénoménale de la technique (comme il en existe des multitudes). La critique catégorielle, menée assez loin, supprime les moyens termes bancals et les faux-fuyants théoriques des deux côtés : elle fait converger des segments de critique jusque-là isolés les uns des autres.

La conclusion anti-industrielle de mon livre n’est que la conséquence logique de l’enchaînement qui précède. Je n’avais aucun agenda de cette sorte en commençant à écrire le livre. J’ai bien sûr, comme tout un chacun, mes « préférences pulsionnelles », comme les nommait si bien Freud. Mais je demande à être jugée sur la pertinence de la démonstration et non aux éventuelles préférences qu’on me prête. Car plus j’avançais, plus s’imposait l’évidence de la conclusion, qu’elle plaise ou non : il n’y a pas moyen de maintenir une société industrielle planétaire sur la durée. Et ceci se déduit non pas de considérations vagues sur la « civilisation », mais de l’examen du rapport social capitaliste lui-même. Les conséquences d’une démonstration ne sont pas là pour plaire à quelqu’un. La collusion bien connue entre le capitalisme industriel et le marxisme traditionnel n’en est que plus flagrante. Cette collusion a certes été critiquée par la critique de la valeur et par l’écosocialisme et l’écomarxisme (contrairement aux autres courants postmarxistes). Mais aucune de ces tendances ne va au bout de cette critique : un résidu de marxisme traditionnel apparemment inéliminable.

En dépit des malentendus, la raison pour laquelle je ne poursuivais pas un agenda anti-industriel est celle-ci : mon thème était, à la lumière de la crise climatique et énergétique traitée dans le livre de Konicz, le replacement de la catégorie abstraite d’énergie dans la dynamique du développement capitaliste des forces productives. La critique anti-industrielle n’était pas du tout le premier objet de recherche mais arrivait – presqu’inopinément – en position seconde. Je tiens pour nécessaire que la critique anti-industrielle s’impose comme une conséquence de la critique précédente et non comme sa prémisse idéologique : il ne suffit pas de dénoncer les ravages de l’industrie pour avoir compris sa logique interne de développement. Il ne suffit pas non plus de « sauver » de la critique certaines productions industrielles au nom de la sacro-sainte valeur d’usage (ou de ses propres « préférences pulsionnelles ») pour en être quitte avec cette analyse. Cette discussion exige qu’on s’intéresse à la démonstration du rapport interne, intime et nécessaire, entre catégorie du travail et catégorie d’énergie dans le capitalisme.

La catégorie abstraite d’énergie

Comme l’indique le titre du livre, l’énergie était donc son objet central. Dans son article, Meyer réduit cet objet au rappel des lois de la thermodynamique qu’il plaque sur un long résumé des thèses de Marx et de la critique de la valeur (p. 199). Selon lui, la thermodynamique nous rappelle que l’exploitation de la nature a des limites ; nous devons donc en tenir compte. La thermodynamique a la fonction d’une connaissance acquise au sein du capitalisme mais extérieure au capitalisme : « Il se peut bien que ces rapports [entre capitalisme et entropie] n’aient été découverts qu’avec le capitalisme, mais il est bien connu que genèse et validité ne sont pas la même chose (ce que personne ne conteste en dehors de quelques constructivistes radicaux). Il s’agit donc bien d’une limite naturelle, mais le moment et la manière dont elle est atteinte dépendent de la forme de société et de son processus de métabolisme avec la nature. » (p. 214).

Meyer réitère la même approche transhistorique de la notion d’énergie que je critique dans mon livre à l’aide de nombreux exemples (qu’il ne cite pas du tout). Il ressert des généralités courantes sur la civilisation qui n’ont rien à voir avec l’objet examiné, à savoir le capitalisme industriel : « Une civilisation technique ne peut évidemment exister que pour un temps limité sur une planète, même si elle est non capitaliste. » (p. 214). L’auteur accepte donc froidement de condamner l’humanité pour sauver ce qu’il appelle la « civilisation technique ». Pourquoi me fais-je accuser à longueur de page de « darwinisme social » si telle est bien son idée ?

Il ajoute : « Le mur énergétique n’a donc pas vraiment de rapport avec la borne interne de la valorisation du capital. » (p. 215). Qu’est-ce que cela signifie ? Pas vraiment, pas du tout, ou un peu quand même ? Meyer évite systématiquement d’examiner le rapport entre la borne interne et la borne externe ; puis il évite d’examiner le rapport entre le concept de travail abstrait et le concept d’énergie abstraite. De cette façon, il peut formuler une généralité vague et consensuelle sur l’énergie qui est celle de la science et de l’économie officielles. Nombreux sont les auteurs qui excellent à fondre la catégorie abstraite d’énergie dans le grand continuum de l’aventure humaine, comme ils le font du travail ou de l’économie. Les néoclassiques raffolent de ce procédé théorique naturalisant lorsqu’ils se commettent à parler d’énergie. Mais dans le contexte de la critique de la valeur, il reste à expliquer que des théoriciens qui n’admettent pas qu’on parle de travail, d’économie, d’argent ou de marchandise pour qualifier les échanges antiques transposent quand même la catégorie d’énergie sans problème sur toutes les sociétés passées ou futures. La raison en est une complète méconnaissance de l’énergie comme abstraction opératoire spécifique au mode de production capitaliste.

Il n’est donc pas étonnant que Meyer resserve le plus commun des clichés sur l’énergie, qu’il ne comprend que dans le sens ordinaire concret, puisqu’il n’a pas pris la peine d’entrer dans l’abstraction de ce concept et d’examiner l’articulation que je propose. Il réussit ainsi l’exploit intellectuel de commenter un livre dont le sujet principal est l’énergie en ne parlant pas d’énergie – en dehors d’une petite mention digne d’un résumé de lycée ! Ou plus exactement, il juxtapose simplement son résumé de professeur de lycée sur l’énergie aux analyses de Marx sur le développement des forces productives et la composition organique du capital. Avec cela, il croit en être quitte avec le sujet, alors qu’il n’a fait que le réduire à néant, puisque je ne juxtapose pas ces deux aspects mais en souligne le rapport interne et nécessaire. L’examen du rapport en question et des conséquences que j’en tire risquerait de dégonfler ses ratiocinations empiristes étalées sur des pages au sujet des bonnes techniques que le capitalisme nous lèguera, moyennant une bonne organisation sociale (parmi lesquelles le génie génétique et les engrais chimiques !).

Meyer naturalise et transhistoricise grossièrement toute une série de phénomènes : l’humain a « toujours » exploité de l’énergie (sans le savoir) ; mais aussi l’humain a « toujours » transformé son environnement ; et les processus de génie génétique se produisent aussi dans la nature (p. 214). Quelle plus belle légitimation des biotechnologies que d’affirmer qu’elles ne font que prendre la suite de l’histoire de la terre ? Autant dire aussi que les plantes et les animaux « travaillent » ! C’est ainsi que le capitalisme se vend comme une grande épopée alors qu’il ne fait que conformer et reconfigurer le monde selon ses besoins, dans un sens entièrement différent des anciennes médiations sociales. « La technique » étant ainsi naturalisée par Meyer, le reste de son article peut se concentrer sur le principal, à savoir le scandale de ma supposée technophobie. Il ignore non seulement le noyau de ma démonstration sur le rôle de l’énergie, mais la totalité des deux premières parties, c’est-à-dire plus des deux tiers du livre ! Peut-être ne veut-il pas s’avouer qu’il n’y a rien compris. Auquel cas, il aurait mieux fait de se retenir d’écrire des inepties qui discréditent les apports de la critique de la valeur-dissociation.

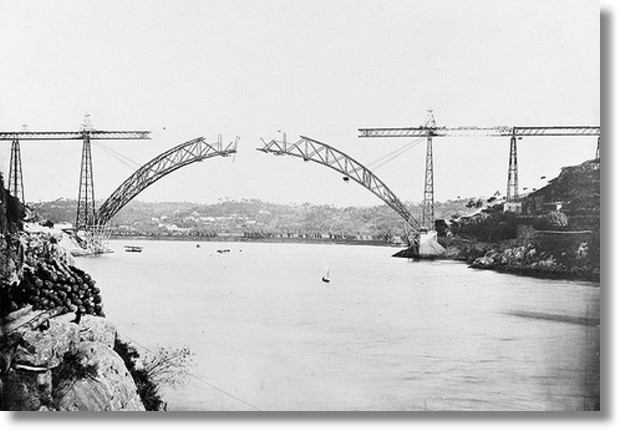

Mais pourquoi devrais-je produire une fois de plus ici la même argumentation que mon livre et mon article incriminés puisqu’ils sont imperturbablement ignorés par Scholz et Meyer ? Il n’y a pire sourd que celui qui ne veut entendre. Allons-y en quelques mots : la composition organique du capital constant et du capital variable est pour Marx un seul et même rapport, variant à chaque époque, considéré une fois du point de vue de la composition-valeur, une fois du point de vue de la composition technique. Ce sont deux aspects de la même chose. Si le rapport de composition organique est dissous, ce sont les deux aspects du rapport (composition-valeur et composition technique) qui disparaissent. Marx ne pense pas le travail mort et le travail vivant séparément. Il est proprement invraisemblable de proposer une « critique radicale » du travail abstrait et de sauver le travail mort de cette critique, comme s’il n’était pas tout à fait abstrait au sens marxien. Je parle à cette occasion dans mon livre des marxistes qui « font comme si on pouvait se débarrasser de la composition-valeur en conservant la composition technique alors que Marx précise bien qu’il s’agit du même procès de production [5]. » Il est tout à fait certain que Marx ne tire pas lui-même la conséquence de sa formulation, car elle contredit son vœu d’une révolution communiste des forces productives mûries. À nous de tirer les conséquences qu’il n’a pas tirées.

Je mets en particulier en évidence que la substituabilité des facteurs de production sur laquelle repose la fonction de production néoclassique dans la combinaison du capital et du travail ou encore du « travail mort » et du « travail vivant » est l’expression même de son abstraction énergétique. L’abstraction énergétique permet de convertir toute forme d’énergie dans une autre. Elle crée par là un régime entropique entièrement nouveau. Ce régime est lié à cette fin en soi capitaliste de convertir une forme d’énergie dans une autre, qui est la face matérielle de la finalité sociale de la valorisation de la valeur : il ne s’agit de rien d’autre que de la totalité du système industriel qui est le doublon matériel de l’abstraction valeur, médiatisé par l’abstraction énergie. Il existe une abondante littérature historique que je ne citerai pas ici, qui montre non pas la naissance simultanée, mais bien une identité catégorielle dans l’émergence des concepts de travail dans la mécanique industrielle (celle des ingénieurs) et dans la mécanique rationnelle (qui déboucheront sur la thermodynamique), ainsi que dans la sphère économique. Je parle évidemment ici d’identité catégorielle et non pas d’identité fonctionnelle. Cette identité implique l’émergence de la catégorie d’énergie, dont la définition la plus simple est, je le rappelle, la capacité à effectuer un travail. Il ne peut y avoir substitution des facteurs de production (des « travaux ») sans une unité de mesure abstraite qui est l’énergie.

La science moderne se développe à partir de la matrice de cette identité catégorielle, bien que chaque branche de savoir l’explore localement en développant des concepts fonctionnels propres et irréductibles. Ceci explique aussi bien l’inflation des monismes énergétistes que la formidable explosion du concept d’entropie dans tous les domaines de la culture au XXe siècle : ce phénomène témoigne d’un pressentiment généralisé de cette matrice catégorielle de l’énergie. Mais celle-ci est toujours traitée de manière non catégorielle aboutissant à des propositions réductrices et farfelues que j’examine aussi dans mon livre. La cybernétique et la systémique descendent de ce monisme énergétique.

Comme je l’ai dit, au lieu de prendre l’énergie à sa racine catégorielle, Meyer en fait une catégorie transhistorique. Ce tour de passe-passe lui permet de dégainer une conception naïve de la différence entre forme et contenu, dont le seul objectif, conservateur, est justement de sauver certains contenus. Ces contenus sont déclarés partiellement indemnes de la subsomption capitaliste et peuvent être sauvés de la déconfiture finale. Des contenus produits par et pour le capitalisme seraient miraculeusement indemnes de la forme ? Il s’agit en fait de contenus arbitraires que Meyer estime potentiellement émancipateurs. Ce que Meyer appelle « contenus » n’est qu’un autre mot pour « valeurs d’usage ». Il occulte ainsi l’identité entre valeur d’usage et valeur d’échange, qui sont deux moments logiques de la valeur. Il reprend ainsi la définition transhistorique par Marx de la valeur d’usage que Kurz a justement critiquée dans son texte « Adieu à la valeur d’usage » : « C’est la catégorie de ˝valeur˝ qui synthétise les deux aspects, l’˝usage˝ et la forme sociale abstraite. […] Une nouvelle critique, plus profonde, du capitalisme, ne peut plus être naïve en ce qui concerne le concept de valeur d’usage [6]. »

Mais même chez Kurz, cette critique sans équivoque flanche tout à coup devant la valeur d’usage qui se trouve justement sur la table. L’exemple du brassage de bière ayant traversé les millénaires que cite Kurz dans « Tabula rasa » en défense de « techniques » qui pourraient survivre à la fin du capitalisme est caractéristique d’une confusion, chez lui aussi, entre la « technique » comprise en un sens transhistorique et le régime technologique radicalement nouveau – c’est-à-dire énergétique, selon ma présentation – qu’implique le capitalisme industriel. Ce n’est pas parce que le brassage de bière a pu traverser les millénaires que la production industrielle de bière le pourra. Ce n’est pas parce que les humains fabriquent des chaussures depuis toujours que la production industrielle de chaussures est possible à long terme. Il est consternant de devoir énoncer de telles lapalissades. La question n’est même pas, contrairement aux ratiocinations de Meyer, de savoir si la production industrielle doit survivre ou non, totalement ou partiellement. Je présume qu’elle s’effondrera, parce qu’elle ne fait que manifester le côté matériel de la crise de la valeur et doit donc être emportée dans la même crise finale. Il existe de ceci suffisamment de signes empiriques et d’avertissements scientifiques. C’est du moins le sens de ma démonstration et justifie les réflexions finales du livre sur les conditions nécessaire à des organisations sociales post-capitalistes. J’en admets le caractère excessivement utopiste, bien qu’il ne le soit pas davantage que de viser l’abolition du travail, de l’argent, de la valeur, de la marchandise et de leur complément fonctionnel, l’État. Cette abolition est de toute façon inconcevable dans l’état présent.

En particulier, l’argument ridicule martelé par Meyer et Scholz, selon lequel la fin de la production industrielle équivaudrait à un « darwinisme social » (leur accusation préférée) peut être renvoyé aux envoyeurs. La suppression du travail et de l’argent équivaudrait pareillement dans les conditions présentes à sacrifier l’existence de millions de personnes ; la fin de l’État jetterait toute la société dans l’anomie et la violence. Il en va de la suppression (abstraite et théorique) de la production industrielle comme des autres catégories du capitalisme. Nul ne peut dire comment doivent se passer les choses ni comment elles se passeront. Elles peuvent avoir des conséquences catastrophiques dans tous les cas. Meyer et Scholz se réservent l’honneur d’une réflexion abstraite et préservée de toute implication négative – en insistant sur son découplage avec une pratique immédiate – mais coulent leur adversaire en choisissant de prendre ses arguments au niveau de l’immédiate concrétude. Ce faisant, ils me refusent le niveau d’abstraction qu’ils se réservent, défigurent mes arguments et croient en avoir triomphé en faisant de moi quasiment une criminelle de masse !

Revenons à la valeur d’usage. Le sujet moderne juge de la valeur d’usage en fonction de son « utilité » (par exemple la médecine de pointe sous la plume de Meyer) au sens économique standard et ne s’interroge aucunement sur ses conditions globales de possibilité, qui sont l’excroissance matérielle adéquate de la production abstraite de valeur. Le simple examen empirique des dizaines ou centaines de substances différentes, avec leurs nombreuses étapes (la plupart toxiques et polluantes) d’extraction, de fabrications, de distribution, etc. nécessaires pour produire la moindre valeur d’usage devrait pourtant l’en avertir. Moyennant la critique kurzienne, toute valeur d’usage tombe aussi sous le coup de ce que disait Engels de la valeur tout court : « Vouloir abolir la forme de production capitaliste en instaurant la ˝vraie valeur˝, c’est vouloir abolir le catholicisme en instaurant le ˝vrai˝ pape, ou instaurer une société dans laquelle les producteurs dominent enfin un jour leur produit, par la mise en œuvre conséquente d’une catégorie économique qui est l’expression la plus ample de l’asservissement du producteur à son propre produit. » (Anti-Dühring). Cette affirmation s’applique parfaitement aussi à une demande abstraite de sauver la « vraie valeur d’usage » sur les décombres d’une prétendue abolition de la valeur.

C’est le même sujet bourgeois qui s’imagine pouvoir régler « consciemment » et « rationnellement », à l’aide d’une hypothétique faculté de contrôle social (p. 212-213), la production industrielle des valeurs d’usage, dans le sens amélioré que réclame sa bonne conscience. Meyer ignore qu’il ne fait par là que chanter les louanges de cette même conscience bourgeoise car aucune société au monde n’a fonctionné sur la base de l’efficience matérielle utilitariste avant le capitalisme. Lui et d’autres proposent ainsi de bâtir une autre société sur la base d’un utilitarisme libéral recyclé qui fut nommé socialisme. Quant au nécessaire approfondissement d’une critique structurelle (et non pas phénoménale ou psychosociale) du sujet bourgeois, il ne risque pas de se produire lorsqu’on affirme comme Meyer que l’inconscient, c’est le cerveau (p. 204). Cette identification positiviste équivaut à celle qui consiste à confondre la valeur avec les prix et montre par là qu’il n’a aucune notion élémentaire de la psychanalyse.

Les valeurs d’usage ne doivent rien au vécu de l’usager. L’usager mesure ces « utilités » à partir de sa condition de monade bornée, séparée de ses relations sociales objectivées, réagissant aux stimuli du marché perçus comme des objets « naturels » de consommation immédiate. Consommateur ou déshérité, c’est le même sujet qui déambule au milieu des valeurs d’usage, réelles ou imaginaires, devant les vitrines ou derrière les écrans, en croyant qu’elles lui sont destinées par nature. Ce sujet continue de nager dans la même illusion quand il croit pouvoir extraire de cet océan d’hallucinations des « utilités » susceptibles de survivre au naufrage final. Car, si des produits et des techniques doivent survivre, elles n’auront pas la forme-marchandise, c’est-à-dire capitaliste et industrielle, que nous leur connaissons ; gardons-nous donc de les trier par anticipation comme des enfants gâtés qui croient que le monde doit ressembler à leur chambre d’enfant. Et gardons-nous de traiter de salaud (par exemple de « darwiniste social »), celui qui ne fait que pointer la direction inéluctable de cette logique : elle est de plus en plus incapable de fournir les « biens essentiels », sans parler de les répartir équitablement. Cette ruine générale ne conduit pas seulement vers l’effondrement de l’accumulation capitaliste, mais évidemment celui du système technique (et de son substrat naturel) qu’elle s’est donnée comme « matérialisation adéquate » (Moishe Postone). N’est pas « darwiniste » celui qui le dit, mais celui qui continue de légitimer la pérennisation des dispositifs – à la fois concrets et abstraits – qui ont justement conduisent à cette ruine générale.

Typique du sauvetage pathétique de son petit monde est aussi le recours rebattu, par Meyer, à l’argument selon lequel l’agriculture de subsistance ne pourra pas nourrir l’humanité (p. 205) ou selon lequel ma critique de la technologie industrielle abandonne à leur sort huit milliards d’êtres humains (p. 209). Il propose simplement, comme un pansement sur une jambe de plâtre, de remplacer les monocultures par des polycultures (p. 208). L’interlocuteur est pris en otage de cette vieille recette néolibérale : sommé d’accepter le monde industriel pour sauver (en pure théorie) des milliards d’êtres humains alors que l’agriculture intensive et la production industrielle sont le ravage ! On ne peut pas à la fois demander l’abolition du système producteur de ravages et dire que son abolition véritable jetterait le monde dans un ravage : cette fausse alternative n’est que l’une des apories répressives dans lesquelles nous enferment les contradictions modernes. J’ai déjà commenté plus haut le procédé consistant à se réserver le niveau d’abstraction approprié pour un sauvetage imaginaire de l’humanité, tandis que la théorie de l’adversaire est accusée de pratiquer une catastrophe, imaginaire elle aussi, sur la base d’une imputation pratique. Scholz et Meyer nient ainsi la qualité d’abstraction de mon raisonnement en le traitant comme une vulgaire proposition immédiate.

L’inquiétude anti-malthusienne de Meyer se porte surtout sur les grosses métropoles. Il ne lui vient pas à l’idée que l’urbanisation et la construction de l’espace modernes méritent la même critique radicale. Les métropoles modernes, dont une grosse partie est constituée de bidonvilles avec des centres de plus en plus réservés aux bureaux d’affaire et au tourisme, sont des excroissances parasitaires du système capitaliste. Elles grossissent, comme un cancer, de l’exploitation humaine et naturelle sans limite des zones périphériques invisibles. On n’a pas besoin de romantiser « la vie à la campagne » ou les « traditions indigènes » pour soumettre les métropoles modernes à la même critique impitoyable que le reste. Il est vrai que je ne l’ai pas traité dans mon livre, ne pouvant aborder tous les sujets et le laissant à des personnes plus compétentes. Conformément à l’a priori individualiste du sujet moderne, Meyer éternise, généralise et naturalise la situation d’un intellectuel urbain déléguant à d’autres couches de population toutes les tâches de la reproduction de l’existence qui sont aujourd’hui subsumées sous l’accumulation capitaliste : celles relevant de l’agriculture et de l’élevage, mais aussi celles de l’extraction minière et des immenses complexes de raffinement et de production (dans la perspective défendue par lui du maintien de la production industrielle), qui par définition ne peuvent pas être pratiquées en ville. Son affirmation selon laquelle « il est faux d’assimiler l’exploitation minière à la déprédation » (p. 207) et son recours, pour ce faire, à des exemples prémodernes, témoigne d’une ignorance abyssale des réalités de la mine industrielle. Cette ignorance a aussi été reprochée à l’auteur auquel il emprunte cette idée [7]. On retrouve simplement ici l’éternelle propension petite-bourgeoise à sauver sa peau, c’est-à-dire sa situation et ses privilèges présents. Ainsi, même la théorie prétendument « radicale » est préformatée jusqu’à la racine par le rapport capitaliste et sa forme de vie.

Mon propos était aussi de montrer, en reprenant la grande idée de Nicholas Georgescu-Roegen, qu’il y a identité entre la recherche d’efficience économique et l’entropie. Il ne fait aucun sens cependant de mettre cette proposition au même plan que l’entropie universelle, comme le fait encore Georgescu-Roegen (et mon pourfendeur Thomas Meyer). Georgescu-Roegen considère en effet toutes les affaires humaines comme relevant de l’économique, donc de l’entropie. Cette conception transforme l’économique en ontologie transhistorique et, par voie de conséquence, l’entropie en destin fatal que nous ne pouvons que retarder, dans le meilleur des cas. C’est mesurer les problèmes de la société industrielle aux temps géologiques sans tenir compte de niveaux de temporalité irréductibles les uns aux autres. Cette vision aussi défendue par Meyer confond les niveaux socio-historique et cosmique d’analyse, ainsi que les niveaux concret et abstrait – une faute épistémologique consternante. Je m’étends longuement sur ces aspects dans mon livre. Meyer les ignore superbement. La même erreur conduit d’ailleurs Georgescu-Roegen à proposer des arrangements avec cette fatalité sous le nom de bioéconomie, soit à brader le meilleur de son intuition. À nous de sortir le noyau de l’écorce.

Abolir le capitalisme, c’est-à-dire la valeur, sans abolir tout principe même d’efficience économique, d’organisation économique, de planification économique, etc. conduit ainsi exactement à la même impasse dans la perspective d’un ordre post-capitaliste. Comme on le voit en lisant Meyer et d’autres, il ne suffit pas de s’interdire le mot « économie » pour en avoir arraché l’idée. Si l’humanité ne parvient pas à se libérer de l’économique sous toutes ses formes – c’est-à-dire aussi sous forme de planification sociale, de calculs d’efficience, d’optimisation de la production, de rendement industriel, etc. que je critique également dans mon livre – elle périra, capitaliste ou non, du mal que le capitalisme lui a insufflé. Et je prétends que ceci n’a rien à voir avec de pures considérations de limites géophysiques, non plus qu’avec une anthropologie transhistorique ou un romantisme agraire.

La machinerie industrielle est la matérialisation immédiate du principe d’efficience économique. C’est de manière essentielle qu’elle incarne l’économisme. Seul le détour par la catégorie polysémique de travail et celle d’énergie abstraite permet de le mettre en évidence. Contrairement aux divagations de Meyer, il n’y pas moyen d’inscrire la machine industrielle dans le continuum transhistorique des « techniques ». Il pratique ainsi la confusion lorsqu’il écrit : « La technique n’est donc pas du capital immédiatement matérialisé » (p. 201). La technique « en général », sûrement pas. Les technologies capitalistes industrielles, si.

Le fantasme d’une production « libérée du capitalisme », où on « prendrait son temps » pour satisfaire de « vrais besoins » dans des usines belles, propres, heureuses et autogérées ne veut rien savoir de leur rapport intrinsèque à la valorisation abstraite d’une part et à la vaste infrastructure capitaliste de conversion énergétique d’autre part. Cette infrastructure est la face matérielle de l’abstraction capitaliste. Meyer veut (abstraitement) abolir l’abstrait en gardant le concret : « L’accumulation de travail mort implique en effet un besoin énergétique croissant, mais certainement pas la construction de machines et de villes en soi. » (p. 203) Pour lui, l’abstrait se meut tout seul, sans son correspondant concret. On pourrait donc arrêter l’abstrait sans perdre le concret qui lui correspond. Meyer ne voit pas qu’il prête le flanc aux critiques qui suspectent une métaphysique dans une telle approche. Il va de soi que la valeur ne marche pas toute seule et qu’elle est accompagnée de son propre doublon concret. Les exemples puisés par Meyer dans des formations prémodernes sont l’essence même de la mauvaise foi, puisque nous sommes en train d’examiner la spécificité de la production capitaliste, qui justement produit et conforme le monde à son image, non pas d’une manière symbolique, comme les sociétés antérieures, mais d’une manière immédiatement concrète et utilitariste.

Quant au « communisme high-tech » de Konicz, il n’est qu’une vision puérile d’automatisme, d’instantanéité de la satisfaction et d’efficacité surnaturelle. Konicz et Meyer se gardent bien de dire quelque chose sur la planification cybernétique qui est pourtant la conséquence directe de leurs positions. Lorsque Meyer nous récite le mantra néolibéral sur la nécessaire réduction (quantitative) des émissions de gaz à effet de serre, le maintien (quantitatif) de la biodiversité, etc. (p. 203) on comprend qu’il accepte pleinement les catégories économiques et gestionnaires de la crise au lieu de les critiquer comme autant de compromis avec l’inacceptable. Il dénonce ainsi le capitalisme d’une main en sauvant la pensée économique, la production industrielle et son discours technocratique de l’autre main.

Robert Kurz avait à la fin de sa vie un grand projet intitulé « travail mort » que j’ai découvert après l’écriture de mon livre. J’imagine qu’il avait une intuition qui aurait pu le conduire dans cette direction de recherche. Il est vrai que je n’en suis pas sûre. Mais eu égard au courage qu’il a eu d’ouvrir envers et contre tout la boite de Pandore de la critique du sujet des Lumières, il n’y pas de raison de penser qu’il aurait reculé devant cette conséquence. Et même s’il arrive à Kurz de reculer, cela ne nous oblige pas à reculer nous-mêmes.

Et maintenant j’ai dépensé assez d’effort à réfuter le tissu d’inepties et de malveillance avec lequel Scholz et Meyer prétendent me critiquer.

Sandrine Aumercier, juin 2024

[1] Thomas Meyer, « Tabula rasa der modernen Technik? Nachtrag und Ergänzung den ˝Artefakten der Geschichte˝ und der ˝Energieschranke des Kapitals˝», exit! – Krise und Kritik der Warengesellschaft, 2024 ; Roswitha Scholz, « Eine Metatheorie der Verschwörungstheorien? Eine Replik auf Sandrine Aumerciers Überlegungen zur Auseinandersetzung um Corona – bei exit! », exit! – Krise und Kritik der Warengesellschaft, 2024.

[2] Sandrine Aumercier, « Théories des théories du complot », 2023, en ligne : <https://grundrissedotblog.wordpress.com/2023/03/10/theorie-des-theories-du-complot/>

[3] Thomas Konicz, Klimakiller Kapital, Mandelbaum, 2020, p. 318 et p. 313.

[4] Sandrine Aumercier, « Travail mort, travail vivant : le gouffre énergétique de la société du travail », Jaggernaut 4, 2022.

[5] Sandrine Aumercier, Le mur énergétique, Albi, Crise & Critique, 2022, p. 194.

[6] Robert Kurz, « Adieu à la valeur d’usage », Neues Deutschland, 28/05/2004.

[7] Volker Weide, Bergbau gleicht Raubbau?, Springer, Berlin, 2020 ; Katja Maria Engel, « Bergbau und Rohstoffe », Spektrum, 03/08/2021.